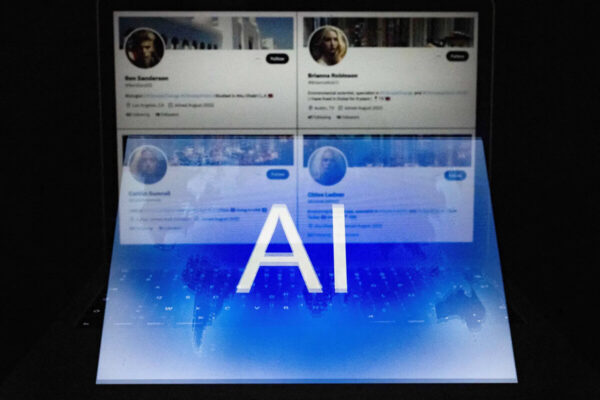

La inteligencia artificial está llegando a un punto en el que herramientas ampliamente accesibles permiten la creación sintética de materiales de gran realismo: imágenes, audio y, cada vez más, secuencias de vídeo generadas íntegramente por la IA.

Mientras la industria avanza a pasos agigantados y el ojo humano se esfuerza por distinguir lo real de lo artificial, algunos expertos y empresarios se han apresurado a idear soluciones.

El espacio digital está a punto de volverse cada vez más traicionero, sugieren varios expertos consultados por The Epoch Times.

Las fabricaciones de alta calidad ya son rápidas y fáciles de producir. Han surgido servicios de verificación que utilizan la IA para detectarlas. La progresión lógica, sin embargo, será una carrera armamentista entre los generadores de IA y los detectores de IA, que dará lugar a falsificaciones cada vez más sofisticadas.

El resultado será una realidad virtual en la que los usuarios perderán en gran medida la capacidad de discernir entre lo auténtico y lo falso a partir del propio contenido. Cada vez más, tendrán que confiar en servicios de verificación de terceros o en fuentes de información que hayan desarrollado un sólido historial de autenticidad.

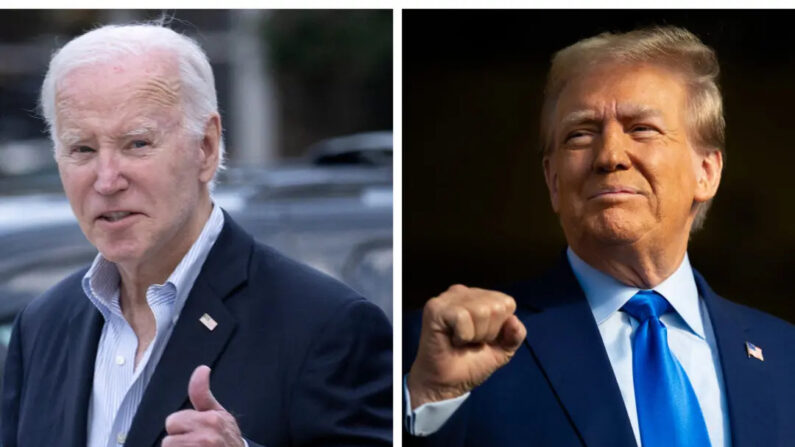

Es probable que la cuestión atraiga la atención en la próxima temporada electoral, en medio de la creciente preocupación por la autenticidad de la información política.

El poder del vídeo

La IA generativa mejoró a pasos agigantados el año pasado, pasando de una sorprendente destreza a un realismo espeluznante.

«Vimos desde el comienzo de 2023 hasta el final de 2023, las imágenes como que pasan la prueba del ojo», dijo Anatoly Kvitnitsky, fundador y director ejecutivo del servicio de detección de inteligencia artificial AI or Not.

«Nuestra predicción es que el vídeo va a tener un momento similar en 2024».

El vídeo realista con IA está «definitivamente a nuestro alcance», afirma Robert Marks, profesor de informática de la Universidad de Baylor que ha contribuido significativamente al campo del aprendizaje automático.

«En el futuro, se podrá hacer desde cero y será realmente realista», declaró a The Epoch Times.

Algunos de los expertos señalaron que la información falsa, política o de otro tipo, no es un fenómeno nuevo, y que hace tiempo que es posible fabricar imágenes.

«El material falso existe desde hace mucho, mucho tiempo. … Lo que ocurre es que ahora disponemos de una forma automática de generarlo», afirma Marks.

Sin embargo, producir imágenes de vídeo falsas siempre ha sido complicado y ha requerido muchos recursos. Por lo general, los vídeos falsos consisten en manipular imágenes reales.

La posibilidad de un vídeo realista hecho desde cero presenta un peligro a un nuevo nivel, según John Maly, ingeniero informático y abogado especializado en propiedad intelectual que ha profundizado en la cuestión del uso y abuso de la IA.

«El peligro de un vídeo es que es mucho más impactante», declaró a The Epoch Times.

Al igual que en elecciones anteriores, si aparece un «dossier» con acusaciones sobre un candidato, «el ciudadano medio no lo va a leer», afirma Maly. Lo más probable es que la mayoría de la gente se entere de lo esencial de las acusaciones a través del filtro de su medio de comunicación preferido, siempre que éste decida cubrirlas en primer lugar.

Pero el vídeo es diferente.

Si hay un vídeo de 30 segundos en el que alguien utiliza insultos racistas o algo parecido, va a tener un impacto inmediato en todo el mundo», dijo Maly.

«Y creo que esa inmediatez va a ser lo que la convierta realmente en una herramienta más peligrosa que las demás».

La IA abriría poderosas herramientas de desinformación a grupos e individuos que son demasiado marginales para obtener los recursos que antes se necesitaban para acceder a tales capacidades, dijo.

«Los activistas pueden reunir estos elementos a bajo coste, filtrarlos y hacerlos circular», afirmó Maly.

La IA también podría aumentar el secretismo de las operaciones de desinformación.

Si se organizara un acto falso, por ejemplo, el riesgo de que saliera a la luz aumentaría con cada participante. Crear toda la escena digitalmente reduce drásticamente el número de personas que conocen el plan.

«Una persona puede guionizar y crear todo un vídeo deepfake, y solo esa persona sabrá que lo ha creado, y eso hace que sea mucho más difícil de rastrear después del hecho», dijo el Maly.

El creador de contenidos McKenzi Brooke (izquierda), de Los Ángeles, junto a una representación de un gemelo de inteligencia artificial en el stand de Hollo AI en Pepcom, antes de la feria tecnológica CES de Las Vegas, el 8 de enero de 2024. (John Locher/Foto AP)

Tiempo hasta la madurez

Hasta ahora, la IA se ha utilizado con éxito para manipular vídeo, por ejemplo añadiendo o eliminando objetos o manipulando la cara de una persona en el vídeo. Algunas de las herramientas más recientes permiten crear videoclips completamente sintéticos, aunque de momento limitados a unos pocos segundos de duración y a una acción sencilla, como una persona girando la cabeza o caminando por la calle.

Se espera que las capacidades se amplíen considerablemente en los próximos meses.

«Llegará justo a tiempo para crear desinformación en torno a la política, ya que vamos a entrar de lleno en la temporada electoral», declaró Kvitnitsky a The Epoch Times.

Marks no iría tan lejos como para predecir un vídeo de IA totalmente realista para el día de las elecciones, pero no descarta la posibilidad.

«¿Qué ocurrirá en octubre? No lo sé. Pero la aceleración de la inteligencia artificial ha sido asombrosa», afirma.

Marks espera que, si la tecnología se utiliza para influir en las elecciones, lo haga como «sorpresa de octubre», de modo que se reduzca la oportunidad de desacreditarla antes de las votaciones.

Maly predice que aún faltan dos o tres años para que la tecnología de vídeo con IA sea realista.

«No creo que vaya a ser este año, pero creo que la forma en que vamos a descubrir que es posible es que las entidades con los bolsillos más profundos, es decir, los actores gubernamentales de los países del primer mundo, probablemente van a ser uno de los primeros que se las arreglan para empeñar un deepfake indetectable que se detectará mucho más tarde», dijo.

Detección por IA

A pesar de los avances tecnológicos, los contenidos generados por IA han sido, hasta hace muy poco, detectables con un mínimo esfuerzo. Las voces sintetizadas hablan con una inflexión poco natural, sobre todo cuando intentan imitar emociones; las figuras de las imágenes generadas presentan una anatomía poco natural, como dígitos que faltan o sobran.

Sin embargo, en los últimos meses, estos problemas se han mitigado en gran medida. Ahora, los sintetizadores de IA pueden hablar con voces de personas reales de forma viva e incluso animada; las imágenes de IA muestran ahora personas con una textura de piel natural y una anatomía precisa

Sigue habiendo defectos notables, sobre todo en las escenas más complicadas con varias personas en el encuadre. Parece que la IA sigue teniendo problemas con el texto del fondo. Por ejemplo, el rótulo de una tienda en segundo plano suele mostrar texto confuso o sin sentido.

«Sin embargo, si no existen esos ‘indicios’, resulta muy difícil detectarlo, sobre todo en las imágenes de mayor calidad, como las de los modelos más recientes», explica Kvitnitsky.

«En muchos casos, no se detecta a simple vista», afirma Marks.

En los últimos años, varias empresas han desarrollado herramientas que utilizan la IA para detectar contenidos generados por ella.

AI or Not, de Kvitnitsky, es una de ellas.

«Hemos entrenado nuestro modelo con millones de imágenes, tanto reales como generadas por IA. … Hemos hecho lo mismo con el audio», explica.

Kvitnitsky dijo que «siempre hay artefactos que cada modelo de IA deja atrás»: una «combinación de píxeles» o patrones de longitud de onda de sub-segundos en un archivo de audio, que serían ininteligibles para el ojo o el oído humano.

«Es ese nivel de granularidad el que se necesita», afirma.

El sitio web AI or Not no almacena las imágenes ni los archivos de audio que comprueba, por lo que no puede elaborar estadísticas generales sobre la fiabilidad de la herramienta, explica Kvitnitsky. Sí dispone de información de algunos de sus clientes, que afirman que la fiabilidad es del 90 por ciento.

The Epoch Times probó la herramienta con una mezcla de unas 20 fotografías reales e imágenes generadas por IA. La mayoría de las fotos reales eran de personas, en estilo retrato o fotoperiodístico, y editadas para mejorar la iluminación, el contraste y el tono de color. Las imágenes de IA eran todas de personas en estilo cándido, selfie o retrato, producidas por Midjourney V6, una versión recién lanzada de un popular generador de imágenes de IA que ha cosechado excelentes críticas por su realismo. AI or Not identificó correctamente todas las imágenes de IA, pero etiquetó erróneamente una de las fotografías reales como probablemente generada por IA.

El problema de los falsos positivos -confundir contenido humano con artificial- es una de las razones por las que Marks duda de que los detectores de IA puedan ser una «forma eficaz» de hacer frente a los deepfakes. Si las herramientas se utilizaran para identificar contenido falso, y si dicho contenido se retirara y se penalizara a los usuarios por publicarlo, muchos serían castigados injustamente, dijo.

«Ninguna de las técnicas de detección es eficaz al cien por cien», afirma Marks.

YouTube, propiedad de Alphabet, ya ha anunciado que planea poner en marcha nuevas normas que obliguen a los usuarios a autoetiquetar los vídeos que contengan «material realista alterado o sintético», como «un vídeo generado por IA que represente de forma realista un suceso que nunca ocurrió, o contenido que muestre a alguien diciendo o haciendo algo que en realidad no hizo.»

«Los creadores que decidan sistemáticamente no revelar esta información pueden ser objeto de eliminación de contenidos, suspensión del Programa de Socios de YouTube u otras sanciones», señala el anuncio del 14 de noviembre de 2023.

Pero cuando The Epoch Times les preguntó, los portavoces de la empresa no quisieron decir qué método se utilizará para determinar qué contenido está generado por IA y cuál no.

Maly expresó su preocupación por que ese proceso acabe siendo opaco y unidireccional.

«Si se trata de algo como Facebook, no hay mucho proceso de apelación. Tienes un botón que te hace sentir que has apelado, pero no hay un ser humano con el que puedas hablar. No hay ningún caso que realmente puedas presentar», dijo.

Facebook, propiedad de Meta, no respondió a una solicitud de información sobre cómo piensa gestionar los contenidos generados por inteligencia artificial.

Carrera armamentísta

Los detectores de IA tienen otro inconveniente: Según Marks, se les puede engañar.

Se refirió a un artículo de 2022 titulado «Creación, uso, abuso y detección de falsificaciones profundas», escrito por Hany Farid, profesor de informática de la Universidad de California-Berkeley. En él se describe un método denominado «perturbación adversarial», que consiste en añadir a una imagen generada por inteligencia artificial un patrón de ruido imperceptible para el ojo humano, pero que engaña al detector para que considere la imagen como auténtica.

El Epoch Times probó el concepto editando repetidamente algunas de las imágenes de la IA Midjourney V6, especialmente realistas. Al principio, la herramienta AI or Not las etiquetó correctamente como probablemente artificiales, pero tras repetidas ediciones, como añadir y reducir ruido, cambiar el tamaño, aumentar la nitidez y ajustar repetidamente la exposición y el contraste, la mayoría de las imágenes pasaron como «probablemente humanas», aunque también activaron la advertencia de «baja calidad de imagen» de la herramienta.

La advertencia aparece cuando la herramienta detecta cambios en la iluminación, el formato de archivo «y otras técnicas de manipulación», explicó Kvitnitsky en un correo electrónico.

«La intención es proporcionar un indicador si creemos que la imagen requiere más investigación», dijo.

El problema es que todas las fotos auténticas que The Epoch Times utilizó para probar la herramienta también activaron la advertencia de baja calidad.

Kvitnitsky explicó que sus clientes con suscripciones «premium» no sólo reciben el resultado binario «probablemente IA»/»probablemente humano», sino también una «puntuación de confianza» para cada resultado.

Destacó que su equipo mejora continuamente la herramienta, que ahora está en proceso de entrenamiento para detectar imágenes creadas por el nuevo Midjourney V6.

«Encontramos casos extremos, los identificamos dentro de nuestro propio equipo y los resolvemos para asegurarnos de que los detectamos», explicó Kvitnitsky.

El proceso de mejora, sin embargo, funciona en ambos sentidos, señaló Marks.

«Es algo así como la carrera armamentista. Tú inventas una forma de falsificar vídeo, alguien inventa una forma de detectarlo. Pero entonces el otro bando se fija en la forma de detectarlo y se las ingenia para sortearlo», explica.

En última instancia, las falsificaciones «llegarán al punto de ser muy difíciles de detectar», predijo Marks.

Kvitnitsky reconoció que la situación es similar al juego de ponerse al día que los desarrolladores de ciberseguridad juegan con los hackers.

«Intentamos ir por delante, pero sí, eso es exactamente. Es una nueva fase de la ciberseguridad», dijo, señalando que algunos de sus mayores clientes están en el ámbito de la ciberseguridad.

Además, hay algunos obstáculos notables para jugar a ponerse al día en el imperfecto mundo de la información, dijo el Sr. Maly.

Por un lado, los modelos generativos de IA no se desarrollan necesariamente de forma incremental.

«Cada dos o tres años los cierran por completo y empiezan de cero. Y puede que el usuario no se dé cuenta, porque siguen teniendo el mismo front-end y el mismo nombre para el producto», explica Maly.

Y un nuevo modelo significa que hay que volver a entrenar la herramienta de detección.

Además, los vídeos artificiales de mayor duración pueden ser bastante complejos y probablemente estén producidos por varias herramientas que dejan cada una sus firmas, que luego se mezclan en el producto final.

«Cuanto más sinteticemos múltiples cosas en un producto de alto nivel, más difícil será detectar el origen de los distintos componentes», afirma Maly.

Las falsificaciones también serán más fáciles de ocultar cuando representen acontecimientos caóticos, como una guerra o una revuelta.

«Quizá tengan un ángulo de cámara extraño, estén borrosas o haya agua o suciedad en la cámara», explica.

«Así que creo que probablemente sería más aceptable la ofuscación de ese tipo de imágenes porque estamos acostumbrados a que tengan una calidad imperfecta».

Firmas digitales

Algunas empresas y organizaciones no gubernamentales han propuesto erradicar las deepfakes mediante «firmas criptográficas.»

La idea es que el software que produce un contenido almacene en él cierta información codificada, como cuándo, dónde y por quién fue creado. Una versión cifrada del código se almacenaría en un lugar de confianza. Así sería posible comprobar la «procedencia» del contenido.

«Las empresas deben desarrollar métodos eficaces para etiquetar los contenidos generados por IA, lo que implica el uso de una firma criptográfica, y coordinarse con la sociedad civil para estandarizar la forma en que la industria documenta la procedencia de contenidos específicos», afirma Freedom House, un grupo de defensa de los derechos humanos, en sus recomendaciones políticas sobre IA para 2023. El grupo también sugiere que las empresas «inviertan en el desarrollo de software para detectar contenido generado por IA.»

«La ventaja de estos enfoques basados en la procedencia es que pueden hacer frente a la creación y el consumo de contenidos a escala de Internet», afirma Farid en su documento de 2022.

«La desventaja es que requerirán una amplia adopción por parte de creadores, editores y gigantes de las redes sociales».

No parece que vaya a haber una amplia adopción. Uno de los problemas del sistema se reduce a la privacidad. Una sociedad libre no tiene por qué facilitar a las autoridades el rastreo del origen de cada información, sobre todo cuando se trata de discursos políticos.

Los partidarios del sistema proponen así una variante que permitiría a los creadores de contenidos limitar qué información de «procedencia» desean compartir. En ese caso, sin embargo, el sistema no probaría la exactitud de la información en sí, sino simplemente que se trata de la información que el creador desea compartir.

Impacto más amplio

Es probable que la introducción de creaciones realistas de IA reconfigure la cultura online y erosione la confianza en la información digital que carece de autenticación offline.

«Diferenciar la verdad va a ser mucho más difícil ahora que nunca», afirma Marks.

Incluso sin ninguna sorpresa de deepfake, la mera existencia de herramientas de deepfake crea lo que el Sr. Farid llamó el «dividendo del mentiroso», en el que la gente puede tratar de descartar la información genuina como falsa.

Considera «probable» que «sea necesaria alguna versión de una solución basada en la procedencia, junto con los esquemas de detección… para ayudar a restablecer la confianza en los contenidos en línea».

Kvitnitsky expresó su confianza en que su empresa ayudará a apuntalar esa confianza.

Sin embargo, confiar en la IA para contrarrestarla lleva necesariamente a los usuarios a ceder el control sobre el discernimiento de la verdad, dijo Maly.

«Este parece ser exactamente el ecosistema social en el que estamos a punto de entrar: [No] confiamos en que las IA no nos estén engañando, pero la única forma de comprobarlo es utilizando otras IA que no hemos creado nosotros», dijo en una respuesta por correo electrónico.

Esto podría llevar incluso a una situación en la que unas pocas empresas tecnológicas gigantes ofrecieran tanto generación como detección de IA, «controlando ambos lados de la ecuación», dijo Maly.

Según él, es poco probable que las herramientas de detección puedan ser examinadas.

«Si la inteligencia artificial es de código abierto para que pueda ser examinada, entonces puede ser diseccionada y eludida, por lo que mi conjetura es que será un ecosistema de soluciones cerradas y patentadas, como ya tenemos con el software antivirus: hay nombres de confianza, pero todavía estamos haciendo suposiciones sobre las prácticas de seguridad y los motivos de nuestro proveedor», dijo Maly.

Será crucial que la gente se eduque sobre el funcionamiento y las capacidades de la IA, afirmó.

«Cierto grado de conocimiento de las IA y seguir las noticias sobre IA será obligatorio para cualquiera que quiera tener alguna esperanza de saber la verdad, de lo contrario confiar en los datos generados por IA se convierte casi en basar tu vida en un juguete de bola ocho mágica», dijo Maly. «Podría decirse que la complacencia siempre ha sido enemiga de la verdad, pero su coste para la opinión de la sociedad está a punto de ser mucho mayor».

Marks sugirió que la gente tendrá que «recurrir a algunas herramientas antiguas» para evaluar la veracidad de los contenidos digitales.

«Te fijas en la fuente, en el grado de interés que tienen en promocionar el artículo. … Hay una serie de herramientas que pueden utilizarse para evaluar la verdad. ¿Son eficaces al cien por cien? No. Pero creo que son increíblemente, increíblemente útiles», dijo.

«No es un problema de la IA, es un problema del problema. Hay desinformación todo el tiempo. Y el problema del problema es que la gente publica cosas falsas y tienes que averiguar si son ciertas o no».

«La falsificación se ha vuelto más realista gracias a la inteligencia artificial, pero el problema sigue siendo el mismo. Y no creo que haya otra forma de hacerlo que no sea la prensa libre y el discurso político»

Únase a nuestro canal de Telegram para recibir las últimas noticias al instante haciendo click aquí

Cómo puede usted ayudarnos a seguir informando

¿Por qué necesitamos su ayuda para financiar nuestra cobertura informativa en Estados Unidos y en todo el mundo? Porque somos una organización de noticias independiente, libre de la influencia de cualquier gobierno, corporación o partido político. Desde el día que empezamos, hemos enfrentado presiones para silenciarnos, sobre todo del Partido Comunista Chino. Pero no nos doblegaremos. Dependemos de su generosa contribución para seguir ejerciendo un periodismo tradicional. Juntos, podemos seguir difundiendo la verdad.