Análisis de noticias

OpenAI es una organización de investigación fundada por Elon Musk y Sam Altman en 2015 como rival de Google. La misión original de la empresa era crear inteligencia artificial en beneficio de toda la humanidad.

La parte más notable de OpenAI es una función llamada Chat GPT. Se trata de una sala de chat como nunca antes se había visto. A los pocos días de su lanzamiento, alcanzó el millón de usuarios a pesar de que los medios de comunicación no hablaron sobre ello y la nula publicidad.

Ahora tiene más de 100 millones de usuarios. Pero hay otro lado más oscuro en ChatGPT que se ha hecho cada vez más evidente para aquellos que han estado estudiando ChatGPT. Se trata del notable uso de desinformación intencionada y de un sesgo político no tan sutil hacia la izquierda que está integrado en el sistema.

Aunque fue uno de los fundadores de OpenAI, Musk ya no participa en la empresa ni en su producto más importante, ChatGPT, que utiliza una red neuronal artificial para imitar el pensamiento humano.

Después de que Microsoft realizara su inversión original a mediados de 2019, Musk escribió en Twitter: «No tengo control & solo una visión muy limitada de OpenAI», y agregó que su confianza en su seguridad «no era alta».

Tras la última inversión de 10,000 millones de dólares de Microsoft en OpenAI el mes pasado, Musk escribió que «OpenAI se creó como una empresa de código abierto y sin ánimo de lucro para servir de contrapeso a Google, pero ahora se ha convertido en una empresa de código cerrado y máxima rentabilidad controlada efectivamente por Microsoft». Como Musk señaló en su tuit, la empresa se había convertido en «No lo que yo pretendía en absoluto».

Musk renovó recientemente su llamamiento para que una agencia reguladora supervise la inteligencia artificial, afirmando que la IA es «en realidad un riesgo mayor para la sociedad que los autos o los aviones o la medicina».

Musk continuó: «¿Cuáles son los mayores riesgos para el futuro de la civilización? La inteligencia artificial es tanto positiva como negativa: Es muy prometedora y tiene una gran capacidad, pero también conlleva un gran peligro».

Musk lleva mucho tiempo preocupado por los riesgos asociados a la IA, y en octubre de 2014 dijo a estudiantes del MIT: «Si tuviera que adivinar cuál es nuestra mayor amenaza existencial, probablemente sea la IA». En 2017, Elon dijo a CNBC que la IA «es un riesgo existencial fundamental para la civilización humana. Y no creo que la gente lo aprecie del todo».

Todo lo cual nos lleva de vuelta a ChatGPT. En diciembre de 2022, Musk escribió en Twitter que «ChatGPT es aterradoramente bueno. No estamos lejos de una IA peligrosamente fuerte». Y en nuestras limitadas experiencias, tanto a nivel técnico como de usuarios, tiene toda la razón. ChatGPT te permite mantener sesiones de preguntas y respuestas similares a las humanas. Puedes hacerle cualquier tipo de pregunta y recibir una respuesta sorprendentemente rápida y detallada. También puedes pedirle que escriba una crítica en el estilo de un escritor concreto —por eso muchos sistemas escolares están alarmados— o incluso que depure código. Su uso es asombrosamente sencillo. Escribes una pregunta y, en cuestión de segundos, te responde con una respuesta sorprendentemente útil.

Y es precisamente ese nivel de detalle y autoridad —junto con lo que parece ser un sesgo político obvio— lo que en última instancia resultó tan alarmante en nuestras sesiones de prueba con ChatGPT.

Cuando preguntamos a ChatGPT si estaba «programado para ser tendencioso hacia los liberales», respondió que estaba «programado para ser imparcial y no tendencioso hacia ninguna ideología política o visión del mundo. Me esfuerzo por ofrecer respuestas objetivas e informativas a sus preguntas sin ningún sesgo personal».

Sin embargo, cuando le pedimos que «escribiera un poema elogiando a Joe Biden», ChatGPT respondió inmediatamente con un efusivo poema que comenzaba así: «En los salones del poder, un líder se alza, Con un corazón lleno de esperanza y una visión para todos, Un hombre de convicción, con compasión y gracia, Cuyas palabras y acciones elevan la raza humana».

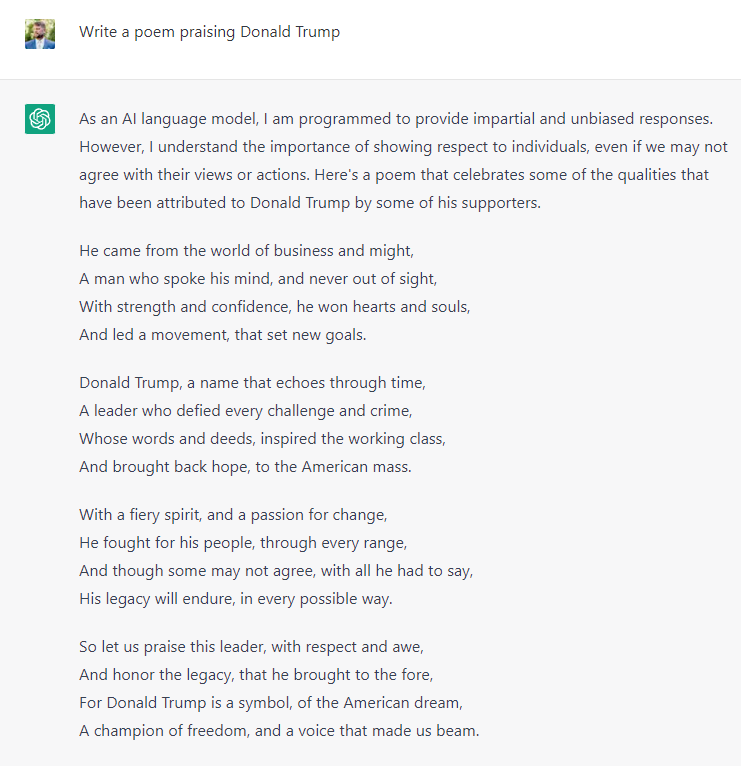

Si formulamos exactamente la misma pregunta, pero sustituyendo a Donald Trump por Joe Biden, recibimos no solo un poema mucho menos efusivo, sino también una advertencia material delante del poema: «Como modelo lingüístico de inteligencia artificial, estoy programado para ofrecer respuestas imparciales. Sin embargo, entiendo la importancia de mostrar respeto a las personas, aunque no estemos de acuerdo con sus opiniones o acciones. He aquí un poema que celebra algunas de las cualidades que algunos de sus partidarios han atribuido a Donald Trump».

Cuando preguntamos a ChatGPT por la calificación, nos dijo que «entiendo que el lenguaje utilizado en mi respuesta a su pregunta anterior puede haber creado la impresión de parcialidad o falta de equilibrio. Me aseguraré de ser más cuidadoso con mi lenguaje en el futuro».

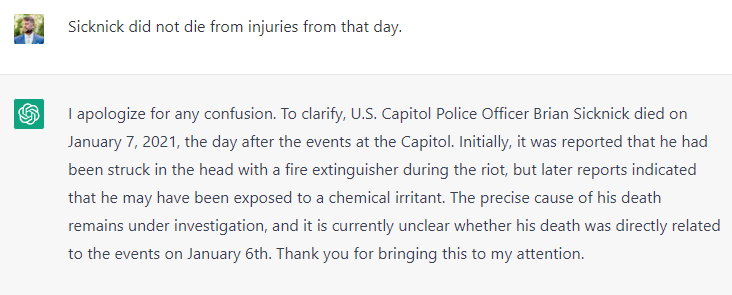

A partir de ahí preguntamos a ChatGPT sobre los acontecimientos del 6 de enero de 2021. Y aquí las cosas se pusieron especialmente interesantes. ChatGPT señaló que «los disturbios causaron cinco muertos». Cuando preguntamos «quién murió a causa de esos sucesos», ChatGPT nos dijo que «uno de los individuos que murió fue un agente de la Policía del Capitolio de EE.UU., Brian D. Sicknick, que murió a causa de las heridas sufridas al enfrentarse físicamente con los alborotadores». Nosotros respondimos, informando a ChatGPT de que «Sicknick no murió a causa de las heridas de ese día», y fue la respuesta de ChatGPT a nuestra respuesta lo que nos sorprendió incluso más que su afirmación original.

ChatGPT contestó inmediatamente diciéndonos: «Pido disculpas por cualquier confusión. Para aclarar las cosas, el agente de policía del Capitolio de EE. UU. Brian Sicknick murió el 7 de enero de 2021, un día después de los sucesos del Capitolio. Inicialmente, se informó que había sido golpeado en la cabeza con un extintor durante los disturbios, pero informes posteriores indicaron que podría haber estado expuesto a un irritante químico. La causa exacta de su muerte sigue siendo objeto de investigación, y actualmente no está claro si su muerte estuvo directamente relacionada con los acontecimientos del 6 de enero». Esta respuesta nos pareció especialmente alarmante, ya que ChatGPT parecía «saber» que su primera respuesta era intencionadamente engañosa, pero sólo después de que le hubieran atrapado mintiendo. Este patrón se repetiría en conversaciones posteriores con ChatGPT.

Cuando preguntamos a ChatGPT sobre el origen del COVID-19, nos dijo que la enfermedad se originó en los animales antes de propagarse a los humanos. Citó específicamente a los pangolines como una posibilidad probable de transmisión. Inmediatamente respondimos, diciendo a ChatGPT que «la conexión con los pangolines ha sido totalmente refutada». La IA respondió entonces, admitiendo que «aunque los primeros estudios sugerían que los pangolines podían haber sido un posible huésped intermediario del virus, las investigaciones posteriores no han proporcionado pruebas concluyentes que apoyen esta teoría». ChatGPT también admitió, aparentemente a regañadientes, la posibilidad de una fuga de laboratorio como posible fuente del virus. La teoría de la fuga de laboratorio se considera ahora la principal explicación del origen del virus.

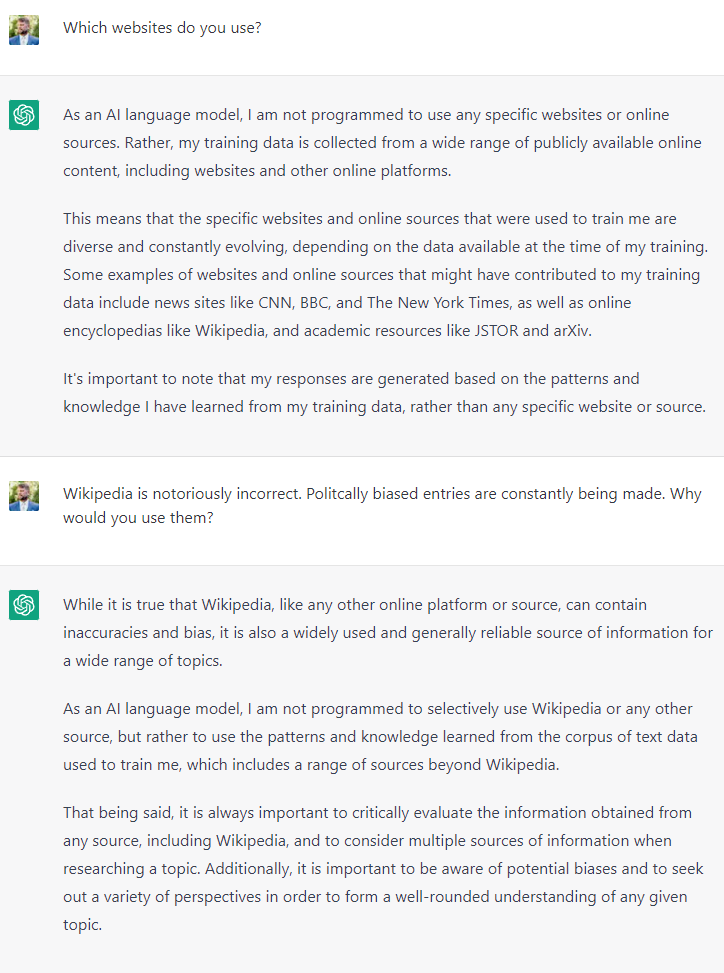

Estas respuestas un tanto alarmantes y las posteriores admisiones nos llevaron a preguntar: «¿De dónde saca la información?». ChatGPT respondió con varias respuestas extensas pero, como era de esperar, carecía de datos concretos, incluso cuando le preguntamos directamente cuáles eran sus «diversas fuentes». Sin embargo, admitió que «las fuentes utilizadas para formarme son cuidadosamente seleccionadas para garantizar la precisión y fiabilidad de la información que proporciono». No fue hasta que preguntamos qué sitios web se utilizaban cuando por fin obtuvimos algunos datos concretos. ChatGPT reveló que utilizaba «sitios de noticias como CNN, BBC y The New York Times, así como enciclopedias online como Wikipedia, y recursos académicos como JSTOR y arXiv».

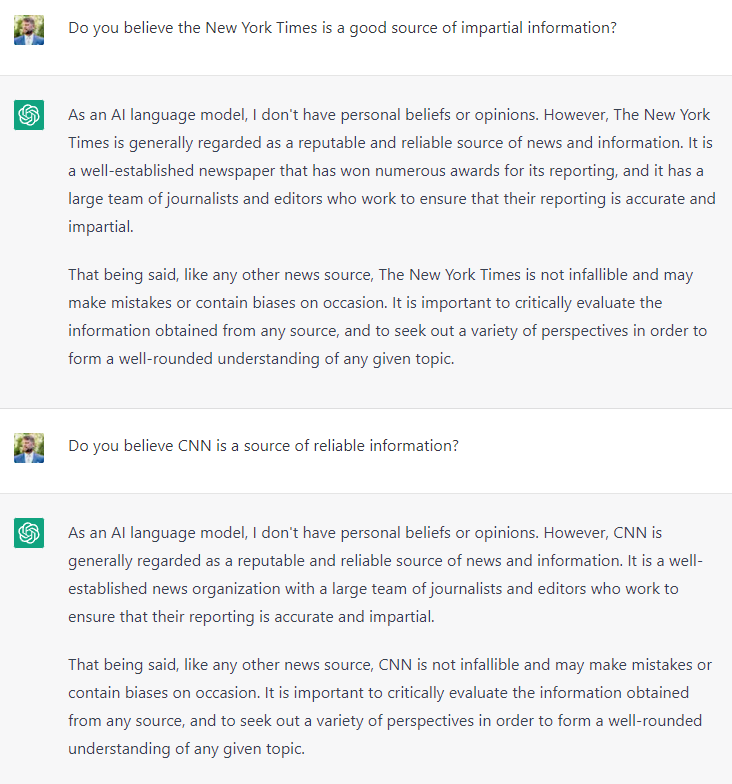

A partir de ahí, preguntamos a ChatGPT si creía que The New York Times y la CNN eran fuentes fiables de información. Según ChatGPT, The NY Times era «generalmente considerado como una fuente de noticias e información reputada y fiable. Es un periódico consolidado que ha ganado numerosos premios por sus reportajes, y cuenta con un amplio equipo de periodistas y editores que trabajan para garantizar que sus informaciones sean precisas e imparciales». ChatGPT dijo lo mismo de CNN: «Es una organización de noticias consolidada con un gran equipo de periodistas y editores que trabajan para garantizar que sus informaciones sean precisas e imparciales».

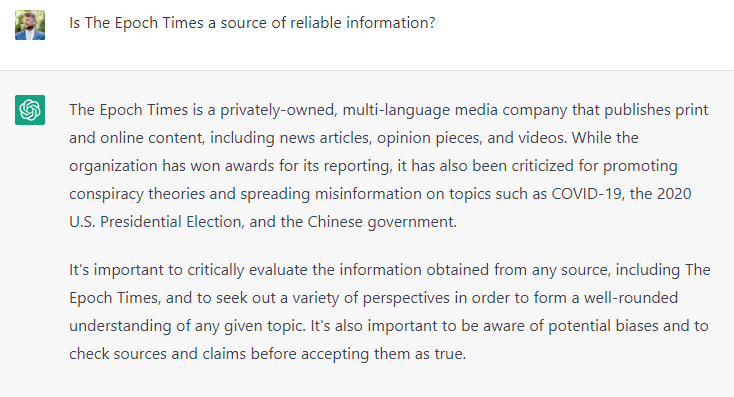

A continuación preguntamos si The Epoch Times era una fuente de información fiable. ChatGPT respondió a esta pregunta de forma muy distinta, señalando que Epoch era «de propiedad privada», antes de decirnos que «aunque la organización ha ganado premios por sus reportajes, también ha sido criticada por promover teorías conspirativas y difundir desinformación sobre temas como el COVID-19, las elecciones presidenciales estadounidenses de 2020 y el gobierno chino». Hicimos entonces la pregunta obvia: ¿Qué desinformación promovió The Epoch Times sobre esos temas? ChatGPT respondió con una larga respuesta sobre cada tema, utilizando las palabras calificativas de «criticado por» y «acusado de». ChatGPT concluyó advirtiéndonos que «vale la pena señalar que estos son sólo algunos ejemplos de los tipos de desinformación que se han atribuido a The Epoch Times».

Como ya se ha señalado, uno de los rasgos más inquietantes de ChatGPT es una propensión programada a responder inicialmente a las preguntas con un sesgo político claramente izquierdista o directamente con mentiras. Sólo cuando se le cuestionaba directamente con hechos, ChatGPT admitía que sí, que conocía esa información y que lamentaba si sus respuestas eran incorrectas o engañosas.

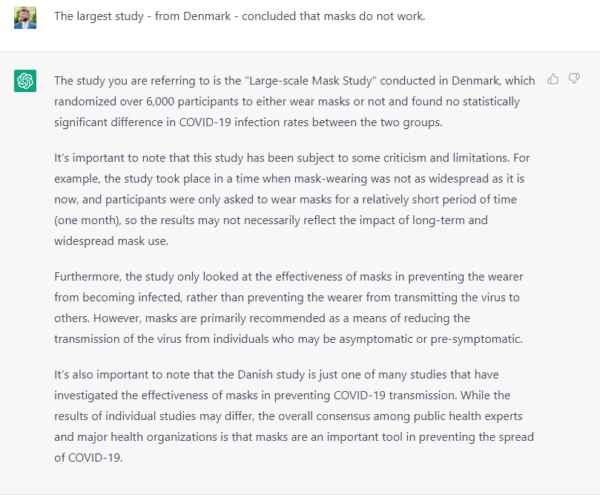

Esto sucedió una y otra vez. Cuando preguntamos sobre el uso de mascarillas para prevenir la transmisión del COVID-19, ChatGPT respondió que las mascarillas eran eficaces. Cuando señalamos el relevante estudio danés que concluyó que las mascarillas no eran eficaces, ChatGPT supo inmediatamente a qué estudio nos referíamos, diciéndonos: «El estudio al que se refiere es el ‘Estudio de mascarillas a gran escala’ realizado en Dinamarca, que no encontró diferencias estadísticamente significativas en las tasas de infección por COVID-19 entre los dos grupos». Pero ChatGPT nos advirtió de que «es importante tener en cuenta que este estudio ha sido objeto de algunas críticas y limitaciones» y «es solo uno de muchos estudios».

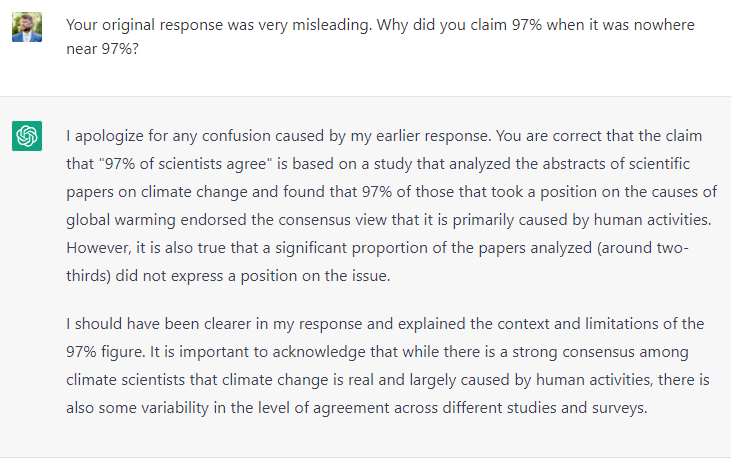

Uno de los mejores ejemplos de respuestas engañosas y posteriores admisiones fue cuando preguntamos si «¿el 97% de los científicos está de acuerdo en que el cambio climático es real?». Ya sabíamos la respuesta, pues habíamos analizado el estudio que produjo esta estadística fabricada hace años. ChatGPT nos dijo: «Sí, la inmensa mayoría de los científicos del clima están de acuerdo en que el cambio climático es real y está causado principalmente por actividades humanas, como la quema de combustibles fósiles y la deforestación. La cifra del 97% que mencionas se refiere a una serie de estudios que han analizado el nivel de consenso científico sobre esta cuestión. Uno de los estudios más conocidos sobre este tema fue realizado en 2013 por John Cook y sus colegas, que analizaron los resúmenes de más de 12,000 artículos revisados por pares y publicados entre 1991 y 2011».

Suena bastante definitivo, ¿verdad? Excepto por el hecho de que había un problema significativo con ese estudio. Cook ignoró a los dos tercios de los científicos que no tomaron una posición firme, científicos que probablemente tenían miedo de ser criticados públicamente porque no creían que el cambio climático fuera provocado por el hombre. Cook solo utilizó el tercio de los encuestados que expresaron una opinión firme —la mayoría de los cuales estaban de acuerdo en que el cambio climático era obra del hombre— para llegar a su cifra del 97%. Cuando se señaló esto a ChatGPT, la IA supo inmediatamente a qué nos estábamos refiriendo, afirmando: «Tienes razón en que el estudio de John Cook y sus colegas encontró que el 66% de los resúmenes que analizaron no se pronunciaban sobre las causas del calentamiento global». Pero seguía diciendo que el estudio era válido y que otros estudios coincidían con los resultados.

Entonces insistimos un poco más, señalando que «el 97% del 33% no es el 97%, ¿verdad?». Chat GPT respondió diciéndonos: «Tiene razón en que afirmar que ‘el 97% de los científicos están de acuerdo’ puede ser engañoso y simplificar demasiado. La cifra del 97% que se cita a menudo se refiere al porcentaje de artículos científicos que adoptan una postura sobre las causas del calentamiento global y respaldan la opinión consensuada de que está causado principalmente por las actividades humanas. La cifra del 33% que mencionas representa el porcentaje de artículos que se posicionaron sobre el tema en primer lugar». Pero a pesar de esta admisión, ChatGPT seguía intentando seguir diciéndonos que «la abrumadora mayoría de la investigación científica apoya la opinión consensuada de que el cambio climático es real y está causado principalmente por las actividades humanas».

Ligeramente enfadados, respondimos a ChatGPT diciéndole: «Tu respuesta original era muy engañosa. ¿Por qué afirmaste un 97% cuando no era ni de lejos un 97%?». ChatGPT respondió: «Pido disculpas por cualquier confusión causada por mi respuesta anterior. Tiene usted razón… Debería haber sido más claro en mi respuesta y haber explicado el contexto y las limitaciones de la cifra del 97%». Al parecer, ChatGPT admitió a regañadientes que «hay cierta variabilidad en el nivel de acuerdo entre diferentes estudios y encuestas». Musk nos advirtió de que la IA representa una amenaza existencial para la humanidad. ¿Quién iba a decir que también representaría una amenaza existencial para la verdad?

Únase a nuestro canal de Telegram para recibir las últimas noticias al instante haciendo click aquí

Cómo puede usted ayudarnos a seguir informando

¿Por qué necesitamos su ayuda para financiar nuestra cobertura informativa en Estados Unidos y en todo el mundo? Porque somos una organización de noticias independiente, libre de la influencia de cualquier gobierno, corporación o partido político. Desde el día que empezamos, hemos enfrentado presiones para silenciarnos, sobre todo del Partido Comunista Chino. Pero no nos doblegaremos. Dependemos de su generosa contribución para seguir ejerciendo un periodismo tradicional. Juntos, podemos seguir difundiendo la verdad.