Las agencias de Estados Unidos y el Reino Unido han presentado conjuntamente un acuerdo internacional para garantizar que los sistemas de inteligencia artificial (IA) permanezcan a salvo de agentes deshonestos y ayudar a los desarrolladores a tomar decisiones en materia de ciberseguridad.

El documento de 20 páginas, publicado por la Agencia de Ciberseguridad y Seguridad de las Infraestructuras (CISA, por sus siglas en inglés) del Departamento de Seguridad Nacional (DHS, por sus siglas en inglés) y el Centro Nacional de Ciberseguridad (NCSC, por sus siglas en inglés) del Reino Unido, contiene una serie de directrices que las empresas tecnológicas deben seguir al crear productos y servicios de IA.

En octubre, el presidente de Estados Unidos, Joe Biden, emitió una orden ejecutiva en la que ordenaba al DHS que promoviera la adopción de normas de seguridad de la IA en todo el mundo. Como parte de la orden del presidente, se pidió al DHS que protegiera las redes e infraestructuras críticas de EE. UU. y redujera los riesgos de la IA en la creación de armas de destrucción masiva.

Desglosadas en cuatro secciones, las directrices contienen recomendaciones para que los desarrolladores las sigan durante cada paso del proceso de diseño, desde el diseño y desarrollo del sistema de IA hasta su despliegue y mantenimiento. Cada sección destaca consideraciones y mitigaciones para ayudar a reducir el riesgo de ciberseguridad en el proceso de desarrollo de un sistema de IA.

También se mencionan en las directrices formas de combatir las amenazas a los sistemas de IA, la protección de los activos relacionados con la IA, como modelos y datos, la liberación responsable de los sistemas de IA y la importancia de la supervisión una vez liberados. Sin embargo, las directrices no parecen jurídicamente vinculantes y, por el momento, sólo son recomendaciones para las empresas tecnológicas que desarrollan IA.

El secretario de Seguridad Nacional, Alejandro Mayorkas, declaró en el comunicado de prensa adjunto que las empresas tecnológicas que sigan estas directrices son vitales para aprovechar los beneficios y, al mismo tiempo, hacer frente a los posibles daños de esta «tecnología pionera».

«Nos encontramos en un punto de inflexión en el desarrollo de la inteligencia artificial, que bien podría ser la tecnología con más consecuencias de nuestro tiempo. La ciberseguridad es clave para crear sistemas de IA seguros y fiables», afirmó Mayorkas.

«Las directrices publicadas hoy conjuntamente por CISA, NCSC y nuestros otros socios internacionales, proporcionan un camino de sentido común para diseñar, desarrollar, desplegar y operar la IA con la ciberseguridad en su núcleo», añadió.

Entre los otros 16 países incluidos en el acuerdo se encuentran Australia, Canadá, Chile, la República Checa, Estonia, Alemania, Israel, Italia, Japón, Nigeria, Polonia y Singapur.

Cautela sobre la IA

Desde el lanzamiento de OpenAIs ChatGPT el 30 de noviembre de 2022, la carrera por desarrollar sistemas de IA se ha acelerado. Sin embargo, los legisladores y algunos líderes tecnológicos han expresado su preocupación por el riesgo de un desarrollo incontrolado de la IA.

El CEO de Tesla, Elon Musk, ha emitido múltiples advertencias sobre los peligros potenciales de la IA y su potencial para la «destrucción de la civilización».

El presidente de la Comisión de Bolsa y Valores (SEC, por su sigla en inglés), Gary Gensler, también alerto sobre la IA en octubre. El Sr. Gensler cree que una crisis financiera derivada del uso generalizado de la IA es «casi inevitable» sin una rápida intervención de los reguladores.

La CIA también ha publicado su propia Hoja de Ruta para la Inteligencia Artificial con el fin de promover los usos beneficiosos de la IA para mejorar las capacidades de ciberseguridad y garantizar que los sistemas de IA estén protegidos de las amenazas cibernéticas.

Senadores de los dos principales partidos también se han unido para presentar un proyecto de ley sobre IA que ordene a las agencias federales crear normas que proporcionen transparencia y responsabilidad a las herramientas de IA.

Según una copia del proyecto de ley bipartidista publicada el 15 de noviembre, la Ley de Investigación, Innovación y Responsabilidad de la Inteligencia Artificial de 2023 pretende establecer marcos que aporten mayor transparencia, responsabilidad y seguridad al desarrollo y funcionamiento de la IA, entre otros objetivos.

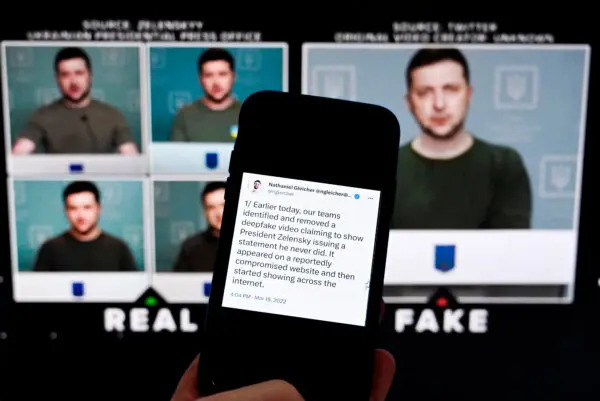

Los deepfakes generados por IA se han señalado como especialmente preocupantes. Esta tecnología de video crea imágenes generadas por ordenador que a menudo no se distinguen de las imágenes reales. Los deepfakes se han utilizado con fines inofensivos, como envejecer a estrellas de cine o crear videos hechos por fans.

Sin embargo, la tecnología también tiene su lado oscuro, ya que podría utilizarse para manipular acontecimientos a escala mundial. El año pasado se difundió un video falso y muy manipulado que mostraba al presidente ucraniano Volodímir Zelenski diciendo a sus soldados que dejaran las armas y se rindieran en la guerra con Rusia.

El video fue desmentido, pero si no lo hubiera sido, las consecuencias podrían haber sido devastadoras para el esfuerzo bélico ucraniano. Aunque el video se considerara legítimo sólo durante unas horas, las fuerzas militares rusas podrían haber obtenido una enorme ventaja que podría haber cambiado la guerra en Europa.

Las empresas tecnológicas ya se están haciendo con el uso de la IA

Algunas de las principales empresas de redes sociales ya han tomado medidas para controlar el uso de la IA a corto plazo.

Meta, la empresa propietaria de Facebook, ha tomado algunas medidas para controlar el uso de la IA durante las elecciones presidenciales de 2024. A principios de este mes, el gigante tecnológico prohibió a las campañas políticas y a los anunciantes de sectores regulados utilizar sus nuevos productos publicitarios de IA generativa.

YouTube también ha anunciado planes para introducir en los próximos meses actualizaciones que informarán a los espectadores de si el contenido que están viendo ha sido creado con IA.

La mayoría de las grandes empresas tecnológicas planean desarrollar productos y servicios de IA o ya los han lanzado. Microsoft, Amazon y Google están entre las más destacadas. Dado que se trata de una tecnología relativamente nueva, queda por ver qué salvaguardas se establecerán para evitar su uso indebido, si es que se establece alguna.

Únase a nuestro canal de Telegram para recibir las últimas noticias al instante haciendo click aquí

Cómo puede usted ayudarnos a seguir informando

¿Por qué necesitamos su ayuda para financiar nuestra cobertura informativa en Estados Unidos y en todo el mundo? Porque somos una organización de noticias independiente, libre de la influencia de cualquier gobierno, corporación o partido político. Desde el día que empezamos, hemos enfrentado presiones para silenciarnos, sobre todo del Partido Comunista Chino. Pero no nos doblegaremos. Dependemos de su generosa contribución para seguir ejerciendo un periodismo tradicional. Juntos, podemos seguir difundiendo la verdad.