Dado que los niños pasan cada vez más tiempo en Internet y muchos suben fotos a sus cuentas de redes sociales, los depredadores sexuales siguen robando estas imágenes para producir material de abuso sexual infantil (CSAM, por sus siglas en inglés).

La proliferación de este material se ve agravada por el fácil acceso a la inteligencia artificial (IA), y las fuerzas policiales y las organizaciones de protección de menores están observando un aumento espectacular del CSAM generado por IA.

Yaron Litwin es experto en seguridad digital y director de marketing de Netspark, la empresa que está detrás de un programa llamado CaseScan que identifica el material de abuso sexual infantil generado por IA en Internet, ayudando a los organismos encargados de hacer cumplir la ley en sus investigaciones.

El Sr. Litwin dijo a The Epoch Times que recomienda a los padres y a los adolescentes que no publiquen fotos en ningún foro público y que los padres hablen con sus hijos sobre los peligros potenciales de revelar información personal en Internet.

«Una de nuestras recomendaciones es ser un poco más cautelosos con las imágenes que se postean en Internet e intentar mantenerlas en redes cerradas, donde sólo haya personas conocidas», dijo el Sr. Litwin.

La Academia Americana de Psiquiatría Infantil y Adolescente declaró en 2020 que, por en promedio, los niños de 8 a 12 años pasan de cuatro a seis horas al día mirando o utilizando pantallas, y los adolescentes hasta 9 horas al día en sus dispositivos.

Parents Together, una organización no gubernamental que proporciona noticias sobre cuestiones que afectan a las familias, publicó un informe en 2023 (pdf) en el que se afirmaba que «a pesar de los malos y cada vez peores riesgos de explotación sexual online, el 97% de los niños utilizan las redes sociales e Internet todos los días, y 1 de cada 5 lo hace ‘casi constantemente'».

Una de las herramientas de seguridad de Netspark es Canopy, una herramienta impulsada por IA que da a los padres el control para filtrar contenidos digitales sexuales nocivos para sus hijos menores, dijo el Sr. Litwin, al mismo tiempo que da a los niños libertad para explorar internet.

Aumento del contenido de explotación

La cantidad de material de abuso sexual infantil online ha aumentado exponencialmente desde que la IA generativa se generalizó a principios de 2023, dijo el Sr. Litwin. El problema es lo suficientemente grave como para que los 50 estados hayan pedido al Congreso que instituya una comisión para estudiar el problema del CSAM generado por IA, dijo.

«Definitivamente existe una correlación entre el aumento del CSAM generado por IA y el momento en que se lanzaron OpenAI y DALL-E y todas estas plataformas de tipo IA generativa», dijo el Sr. Litwin.

El FBI advirtió recientemente al público sobre el aumento de materiales de abuso sexual generados por IA.

«Los actores maliciosos utilizan tecnologías y servicios de manipulación de contenidos para explotar fotos y videos —típicamente capturados de la cuenta de una persona en las redes sociales, de Internet abierto, o solicitados a la víctima— en imágenes de temática sexual que parecen reales en su parecido con la víctima, y luego las hacen circular por las redes sociales, foros públicos o sitios web pornográficos», dijo el FBI en una declaración reciente.

El Sr. Litwin dijo que para proteger realmente a los niños de los depredadores online, es importante que los padres y tutores hablen claramente de los peligros potenciales de publicar fotos y hablar con desconocidos en internet.

«Así que hay que hablar con nuestros hijos sobre algunos de estos riesgos y explicarles que esto puede ocurrir y asegurarse de que son conscientes», dijo.

Peligros de la IA Generativa

Roo Powell, fundadora de Safe from Online Sex Abuse (SOSA), declaró a The Epoch Times que, dado que los depredadores pueden utilizar la imagen de un niño completamente vestido para crear una imagen explícita mediante IA, lo mejor es no publicar ninguna imagen de niños en Internet, aunque sean pequeños, dijo.

«En SOSA, animamos a los padres a no compartir públicamente imágenes o videos de sus hijos en pañales o bañándose. Aunque sus genitales puedan estar técnicamente cubiertos, los autores pueden guardar este contenido para su propia gratificación, o pueden utilizar la IA para hacerlo explícito y luego compartirlo ampliamente», dijo la Sra. Powell en un correo electrónico.

Aunque algunas personas afirman que el material de abuso sexual infantil generado por IA no es tan dañino como las imágenes que muestran abusos sexuales a niños de la vida real, muchos creen que es peor.

El CSAM generado por IA se produce mucho más rápidamente que las imágenes convencionales, lo que inunda a las fuerzas de seguridad con más denuncias de abusos, y los expertos en IA y control parental online esperan que el problema no haga más que empeorar.

En otros casos, la imagen de CSAM generada por IA podría crearse a partir de una foto tomada de la cuenta de redes sociales de un niño de la vida real, que se altera para que sea sexualmente explícita y pone así en peligro a esos niños, que de otro modo no serían víctimas, así como a sus padres.

En el peor de los casos, los malos actores utilizan imágenes de víctimas reales de abusos sexuales a menores como base para crear imágenes generadas por ordenador. Pueden utilizar la fotografía original como entrada inicial, que luego se altera según las indicaciones.

En algunos casos, el sujeto de la foto puede parecer más joven o más viejo.

En 2023, el Observatorio de Internet Standford de la Universidad de Stanford, junto con Thorn, una organización sin ánimo de lucro centrada en la tecnología que ayuda a defender a los niños de los abusos, publicó un informe titulado «ML Generativo y CSAM: Implicaciones y Mitigación», refiriéndose al aprendizaje automático generativo (pdf).

«En sólo los primeros meses de 2023, una serie de avances han aumentado enormemente el control del usuario final sobre los resultados de las imágenes y su realismo resultante, hasta el punto de que algunas imágenes sólo se distinguen de la realidad si el espectador está muy familiarizado con la fotografía, la iluminación y las características de los resultados de los modelos de difusión», afirma el informe.

Los estudios han demostrado que existe una relación entre ver material de abuso sexual infantil y abusar sexualmente de niños en la vida real.

En 2010, el psicólogo forense canadiense Michael C. Seto y sus colegas revisaron varios estudios y descubrieron que entre el 50% y el 60% de las personas que veían CSAM admitían haber abusado de niños.

Incluso si algunas imágenes CSAM generadas por IA no se crean con imágenes de niños reales, las imágenes alimentan el crecimiento del mercado de la explotación infantil al normalizar el CSAM y alimentar el apetito de quienes buscan victimizar a los niños.

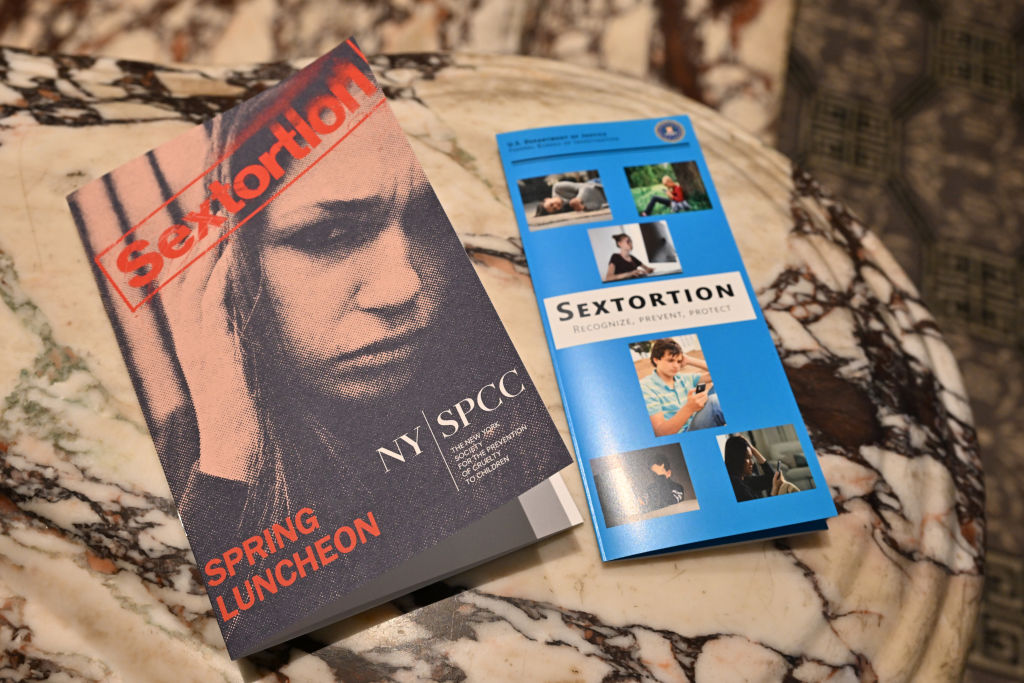

Aumenta la sextorsión

Debido a su realismo, el material de abuso sexual infantil generado por IA está facilitando el aumento de los casos de sextorsión.

La sextorsión se produce cuando un depredador se hace pasar por un joven para solicitar imágenes de desnudos o semidesnudos de una víctima y luego la extorsiona por dinero o actos sexuales bajo amenaza de hacer públicas sus imágenes.

En los casos generados por IA, el delincuente puede alterar la imagen de la víctima para hacerla sexual.

En un caso, el Sr. Litwin dijo que un adolescente aficionado a la halterofilia publicó un selfie sin camiseta que luego fue utilizada por un delincuente para crear una foto suya desnudo generada por IA para extorsionar al menor.

En otros casos, el delincuente podría amenazar con divulgar la imagen, dañando la reputación del menor. Ante tal amenaza, muchos adolescentes acceden a las exigencias del delincuente o acaban quitándose la vida antes que arriesgarse a la humillación pública.

El Centro Nacional para Menores Desaparecidos y Explotados (NCMEC, por sus siglas en inglés) gestiona la CyberTipLine, donde los ciudadanos pueden denunciar la explotación sexual de menores en Internet. En 2022, la línea de denuncia recibió más de 32 millones de informes sobre material de abuso sexual infantil. Aunque algunas de las denuncias se hacen varias veces sobre una sola imagen viral de abuso sexual infantil, sigue siendo un aumento del 82% respecto a 2021, o cerca de 87,000 denuncias al día.

En diciembre de 2022, el FBI estimó en 3000 las víctimas de sextorsión de menores.

«El FBI ha observado un aumento espantoso de las denuncias de tramas de extorsión sexual financiera dirigidas a menores, y el hecho es que las muchas víctimas que tienen miedo de denunciar ni siquiera están incluidas en esas cifras», dijo el director del FBI, Christopher Wray, en una declaración de 2022.

El informe de Parents Together afirma además que «investigaciones recientes muestran que 1 de cada 3 menores puede esperar ahora tener una experiencia sexual no deseada en Internet antes de cumplir los 18 años».

Además, un informe de 2022 de Thorn (pdf) afirma que 1 de cada 6 niños dice haber compartido imágenes explícitas de sí mismos en Internet, y 1 de cada 4 niños dice que esa práctica es normal.

Utilizar la IA buena para luchar contra la IA mala

Antes de la amplia disponibilidad de la IA, editar y generar imágenes requería habilidades y conocimientos de programas de software de edición de imágenes. Sin embargo, la IA lo ha hecho tan rápido y fácil que incluso los usuarios aficionados pueden generar imágenes realistas.

Netspark lidera la lucha contra el material de abuso sexual infantil generado por IA con CaseScan, su propia herramienta de ciberseguridad potenciada por IA, dijo el Sr. Litwin.

Los cuerpos de seguridad deben examinar cantidades ingentes de imágenes cada día y a menudo no pueden revisar todos los informes CSAM a tiempo, dijo el Sr. Litwin, pero es precisamente ahí donde CaseScan puede ayudar a los investigadores.

«Definitivamente creemos que para luchar contra la IA mala, va a venir a través de la IA buena, y ahí es donde estamos centrados», dijo.

Las agencias de seguridad deben examinar cantidades ingentes de imágenes cada día y a menudo no pueden revisar todos los informes CSAM a tiempo, dijo el Sr. Litwin, pero es precisamente ahí donde CaseScan puede ayudar a los investigadores.

A menos que los departamentos de policía utilicen soluciones centradas en la IA, la policía dedica mucho tiempo a evaluar si el niño que aparece en una foto es una falsificación generada por la IA o una víctima real de abusos sexuales. Incluso antes de los contenidos generados por IA, las fuerzas policiales y las organizaciones de seguridad infantil se veían desbordadas por el inmenso volumen de denuncias de CSAM.

Según la legislación estadounidense, el material de abuso sexual infantil generado por IA se trata igual que el material de niños de la vida real, pero el Sr. Litwin dijo que no conoce ningún caso de CSAM generado por IA que haya sido procesado, por lo que aún no hay precedentes.

«Creo que hoy en día es difícil llevarlo a los tribunales, es difícil crear casos sólidos. Y mi opinión es que esa es una de las razones por las que estamos viendo tanto», dijo.

Para procesar a los productores de este CSAM online generado por IA, es necesario actualizar las leyes para que se centren en la actividad delictiva tecnológicamente avanzada que cometen los depredadores sexuales.

El Sr. Litwin dijo que cree que los depredadores siempre encontrarán la manera de eludir los límites tecnológicos establecidos por las empresas de seguridad porque la IA avanza constantemente, pero Netspark también se está adaptando para seguir el ritmo de los que crean CSAM generado por IA.

El Sr. Litwin dijo que CaseScan ha permitido a los investigadores reducir significativamente el tiempo que se tarda en identificar el CSAM generado por IA y aligerar el impacto mental sobre los investigadores que normalmente deben ver las imágenes.

Las empresas tecnológicas deben hacer más

La Sra. Powell dijo que las empresas de redes sociales deben hacer más en la lucha contra el CSAM.

«Para ayudar eficazmente a proteger a los niños y adolescentes, el Congreso puede exigir que las plataformas de redes sociales apliquen sistemas eficaces de moderación de contenidos que identifiquen los casos de abuso y explotación infantil y los remitan a las fuerzas de seguridad cuando sea necesario», dijo.

«El Congreso también puede exigir que todas las plataformas de redes sociales creen funciones de control parental para ayudar a mitigar el riesgo de depredación online. Éstas pueden incluir la posibilidad de que un padre usuario desactive todas las funciones de chat/mensajería, restrinja quién sigue a su hijo y gestione el tiempo de pantalla en la aplicación», añadió.

En abril, el senador Dick Durbin (D-Ill.) presentó la Ley DETENER EL CSAM de 2023, que incluye una disposición que modificaría el artículo 230 de la Ley de Decencia en las Comunicaciones y permitiría a las víctimas de CSAM demandar a las plataformas de redes sociales que alojen, almacenen o pongan a disposición este contenido ilegal.

«Si [las empresas de redes sociales] no ponen en marcha suficientes medidas de seguridad, deberían ser legalmente responsables», dijo el Sr. Durbin durante una reunión del subcomité Judicial del Senado en junio.

La Sra. Powell dijo que cree que el Congreso tiene la responsabilidad de hacer más para mantener a los niños a salvo de los abusos.

«Las leyes deben seguir el ritmo de la constante evolución de la tecnología», dijo, y añadió que las fuerzas policiales también necesitan herramientas que les ayuden a trabajar más rápidamente.

Mejorar el NCMEC

Las representantes Ann Wagner (R-Mo.) and Sylvia Garcia (D-Texas) presentaron recientemente la Ley de Modernización de la Seguridad Infantil en Internet de 2023 para colmar las lagunas existentes en la forma de denunciar los materiales de abuso sexual infantil, garantizando que los delincuentes puedan rendir cuentas.

Actualmente, no existen requisitos sobre lo que las plataformas online deben incluir en un informe a la CyberTipline del NCMEC, lo que a menudo deja a la organización y a las fuerzas de seguridad sin información suficiente para localizar y rescatar al menor. En 2022, esto supuso que cerca del 50% de las denuncias no se pudieron localizar.

Además, la ley no obliga a las plataformas online a informar de los casos de trata y seducción sexual de menores.

Según un informe de Thorn de 2022, la mayoría de los informes de la CyberTipline enviados por la industria tecnológica contenían una información tan limitada que al NCMEC le resultaba imposible identificar dónde se había producido el delito, y por tanto la organización no podía notificarlo a la agencia policial correspondiente.

La Ley de Modernización de la Seguridad Infantil en Internet refuerza la CyberTipline del NCMEC: 1) exigiendo que los informes de las plataformas online incluyan información para identificar y localizar al niño representado y al difusor del CSAM; 2) exigiendo que las plataformas online informen de los casos de tráfico sexual infantil y de incitación sexual a un niño; y 3) permitiendo que el NCMEC comparta los identificadores técnicos asociados al CSAM con organizaciones sin ánimo de lucro.

El proyecto de ley también exige que los informes se conserven durante todo un año, dando a las fuerzas de seguridad el tiempo que necesitan para investigar los delitos.

Stefan Turkheimer, vicepresidente interino de política pública de RAINN (Red Nacional contra la Violación, el Abuso y el Incesto), dijo que el proyecto de ley de la Sra. Wagner es crucial para ayudar a las fuerzas policiales a investigar con éxito las denuncias de CSAM.

«La Ley de Modernización de la Seguridad Infantil en Internet es un paso hacia una mayor cooperación entre las fuerzas policiales y los proveedores de servicios de Internet que apoyará los esfuerzos para investigar, identificar y localizar a los niños que aparecen en los materiales de abuso sexual infantil», declaró Turkheimer en un reciente comunicado de prensa.

Realizar esta mejora es crucial para poner fin a la explotación sexual de los niños, dijo la Sra. Powell.

«En nuestras colaboraciones con las fuerzas policiales, SOSA ha visto cómo un delincuente pasaba del primer mensaje a llegar a casa de un menor para mantener relaciones sexuales en menos de dos horas. Cualquiera con propensión a hacer daño a los niños puede hacerlo rápida y fácilmente desde cualquier parte del mundo con sólo acceder a Internet», afirmó.

Únase a nuestro canal de Telegram para recibir las últimas noticias al instante haciendo click aquí

Cómo puede usted ayudarnos a seguir informando

¿Por qué necesitamos su ayuda para financiar nuestra cobertura informativa en Estados Unidos y en todo el mundo? Porque somos una organización de noticias independiente, libre de la influencia de cualquier gobierno, corporación o partido político. Desde el día que empezamos, hemos enfrentado presiones para silenciarnos, sobre todo del Partido Comunista Chino. Pero no nos doblegaremos. Dependemos de su generosa contribución para seguir ejerciendo un periodismo tradicional. Juntos, podemos seguir difundiendo la verdad.