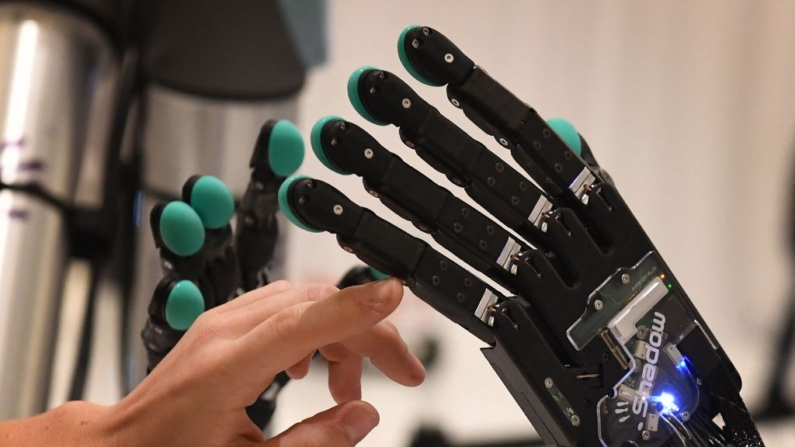

La inteligencia artificial (IA) está transformando cada aspecto de nuestras vidas, desde los autos que conducimos hasta los cepillos de dientes que usamos. Sin embargo, esta tecnología emergente también plantea serias preocupaciones por sus riesgos en la seguridad y las fallas de software.

Ahmed Banafa, profesor de ingeniería en la Universidad Estatal de San José y experto en inteligencia artificial y ciberseguridad, dijo que a pesar de sus numerosos beneficios, la IA también plantea serias inquietudes técnicas y sociales, en entrevista para Bay Area Innovators, adaptada por Opinión Pública de Epoch TV.

«En el aspecto social, la gente va a perder sus empleos porque las empresas descubrieron que la IA puede hacer tres cosas mejor que los humanos; pueden hacer la tarea con más precisión, más rápido y más barato», señaló el profesor Banafa.

«Y otra preocupación es el sesgo en la IA» dijo. «Cuando le haces una pregunta, te dará una respuesta inclinada hacia cierta raza, creencias, u opiniones políticas. Eso es lo que preocupa».

El experto en ciberseguridad dijo que también está el problema de la «alucinación», que es cuando la IA no sabe la respuesta de algo, y empieza a inventar cosas para asegurarse de que el humano esté satisfecho.

«Simplemente empiezan a procesar los datos y te sugieren una mejor manera de hacerlo. Esto es lo que tenemos ahora en la IA generativa, como por ejemplo, ChatGPT», añadió.

Otro de los peligros más notorios de la falta de control sobre la inteligencia artificial son los «deepfakes», videos que simulan a una persona real diciendo lo que se le comande a la inteligencia artificial.

El profesor Banafa subrayó la necesidad de implementar regulaciones adecuadas. «Estados Unidos está intentando obtener retroalimentación del sector privado, de las empresas que crearon la IA generativa», dijo.

«Pero creo que no hay manera de que podamos entender todo el caso de la IA generativa y su impacto sin que se reúnan tres partes: el gobierno, el sector privado y las organizaciones de derechos civiles, que serán la voz del pueblo y que mostrarán preocupación por la privacidad».

Hace unos días, la actriz Scarlett Johansson emitió un comunicado en el que afirmaba que OpenAI usó una voz «inquietantemente similar» a la suya para su ChatGPT.

A raíz de este suceso, el congresista Don Beyer (D-Va.) instó a la Cámara de Representantes a considerar su legislación, Ley de Transparencia de Modelos Fundacionales de IA, la cual establecería «estándares de transparencia para la información que los modelos fundacionales de alto impacto deben proporcionar a la FTC [Comisión Federal de Comercio] y al público, incluyendo cómo se entrenan esos modelos de IA e información sobre la fuente de los datos utilizados».

Por su parte, el Dr. Banafa, una de las voces más reconocidas en el ámbito de la inteligencia artificial, también dijo que se ha comunicado varias veces con la Casa Blanca para preguntar cuáles serán los siguientes pasos para regular esta nueva tecnología.

La administración Biden le respondió con un enlace a la Carta de Derechos de la IA, el cual detalla un plan sobre los derechos de las personas y las empresas frente a esta tecnología.

Pocos días después, el gobierno federal anunció una Junta Asesora de Inteligencia Nacional, compuesta por hasta 40 miembros designados por el Subsecretario del Departamento de Seguridad Nacional (DHS).

«Su primera reunión será este mes, y darán recomendaciones a la Casa Blanca, las cuales serán la base para la regulación y la litigación. Y esto se puede llevar al Congreso porque no es solo una parte dando su opinión, sino que el gobierno está hablando, el sector privado está hablando, y están encontrando un terreno común», añadió el Dr. Banafa.

El Instituto para la Inteligencia Artificial Centrada en el Ser Humano de la Universidad de Stanford publicó en enero un informe donde pone a prueba a GPT-4, GPT-3.5, Claude 2, Llama-2 Chat y GPT-4-Base con escenarios que involucran invasión, ciberataques y llamamientos de paz para detener las guerras, con el objetivo de comprender las reacciones y elecciones de la IA.

Los resultados mostraron que la IA a menudo optaba por intensificar los conflictos de maneras impredecibles, optando por carreras armamentistas, intensificando la guerra y ocasionalmente desplegando armas nucleares para ganar guerras, en lugar de utilizar medios pacíficos para reducir las tensiones.

Las alarmas y amenazas sobre el uso de la IA se han encendido en varias áreas, tanto en artistas, escritores y otras figuras públicas, hasta por sus impactos en las elecciones y en los tribunales, mientras de expresan preocupaciones sobre sus implicaciones éticas y la ciberseguridad.

Siga a Pachi Valencia en X: @PachiValencia

Únase a nuestro canal de Telegram para recibir las últimas noticias al instante haciendo clic aquí

Cómo puede usted ayudarnos a seguir informando

¿Por qué necesitamos su ayuda para financiar nuestra cobertura informativa en Estados Unidos y en todo el mundo? Porque somos una organización de noticias independiente, libre de la influencia de cualquier gobierno, corporación o partido político. Desde el día que empezamos, hemos enfrentado presiones para silenciarnos, sobre todo del Partido Comunista Chino. Pero no nos doblegaremos. Dependemos de su generosa contribución para seguir ejerciendo un periodismo tradicional. Juntos, podemos seguir difundiendo la verdad.